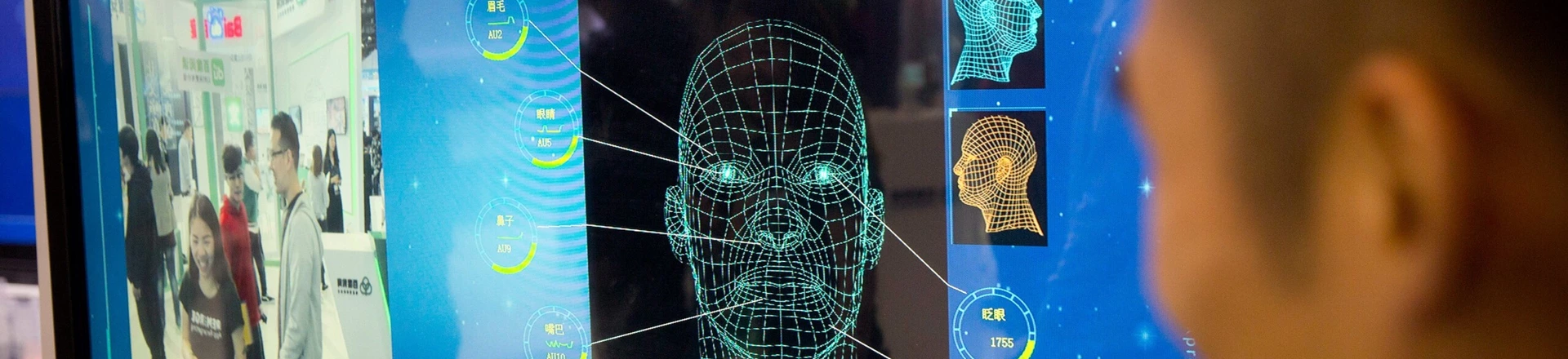

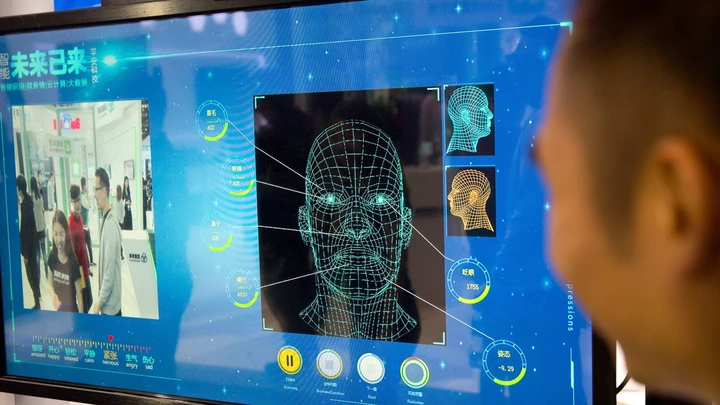

Para muita gente, o reconhecimento facial passou rapidamente de novidade tecnológica a vida real, com milhões de pessoas no mundo todo dispostas a ter seus rostos digitalizados por softwares de aeroporto, iPhones ou fazendas de servidores do Facebook. Mas pesquisadores do instituto AI Now, da Universidade de Nova York, emitiram um forte alerta não só contra o reconhecimento facial onipresente, mas também em relação ao seu parente mais sinistro: o chamado reconhecimento de emoção, tecnologia que afirma poder encontrar um significado oculto na forma do seu nariz e da sua boca e na maneira como você sorri. Se isso soa como algo retirado do século 19, é porque é mais ou menos por aí.

O relatório de 2018 do AI Now é um registro de 56 páginas de como a “inteligência artificial” – um termo abrangente que inclui uma miríade tanto de tentativas científicas para simular o julgamento humano quanto absurdos de marketing – continua a se espalhar sem supervisão, regulamentação ou escrutínio ético significativo. O relatório abrange uma ampla extensão de usos e abusos, incluindo casos de discriminação racial, vigilância policial e de como as leis de sigilo comercial podem ocultar códigos tendenciosos de um público com vigilância da IA. Mas o AI Now, que foi criado no ano passado para lidar com as implicações sociais da inteligência artificial, expressa no documento um receio quanto ao reconhecimento de emoção, “uma subclasse de reconhecimento facial que alega detectar coisas como personalidade, sentimentos íntimos, saúde mental e ‘envolvimento do trabalhador’ com base em imagens ou vídeos de rostos”. A ideia de ter seu chefe observando você por meio de uma câmera que usa aprendizado de máquina para avaliar constantemente seu estado mental é ruim o suficiente, embora a perspectiva da polícia usar “reconhecimento de emoção” para deduzir sua criminalidade futura baseada em “microexpressões” seja exponencialmente pior.

“A capacidade de usar reconhecimento facial e análise massiva de dados para encontrar correlações está levando a algumas alegações muito suspeitas.”

Isso porque o “reconhecimento de emoção”, explica o relatório, é pouco mais do que a informatização da fisiognomia, uma cepa de pseudociência totalmente desacreditada e desmentida de outra época que afirmava que o caráter de uma pessoa podia ser discernido de seus corpos – e de seus rostos, em particular. Não havia razão para acreditar que isso fosse verdade na década de 1880, quando figuras como o desacreditado criminologista italiano Cesare Lombroso promoveram a teoria, e há ainda menos razões para acreditar nisso hoje. Ainda assim, é uma ideia atraente, apesar da falta de base em qualquer ciência, e as empresas centradas em dados aproveitaram a oportunidade para não apenas colocar nomes em rostos, mas para atribuir padrões de comportamento e previsões inteiras a uma relação invisível entre sua sobrancelha e nariz que só pode ser decifrado através do olho de um computador. Há dois anos, estudantes de uma universidade de Xangai publicaram um relatório detalhando o que alegaram ser um método de aprendizado de máquina para determinar a criminalidade com base apenas em características faciais. O artigo foi amplamente criticado, inclusive por Kate Crawford, do AI Now, que disse ao Intercept que se tratava de “frenologia literal… apenas usando ferramentas modernas de aprendizado de máquina supervisionado em vez de pinças”.

Crawford e seus colegas agora se opõem mais do que nunca à disseminação desse tipo de previsão algorítmica cultural e cientificamente regressiva: “Embora a fisiognomia tenha caído em desuso após sua associação com a ciência racial nazista, os pesquisadores estão preocupados com o ressurgimento de ideias fisiognômicas em aplicativos de reconhecimento de emoção”, diz o relatório. “A ideia de que os sistemas de inteligência artificial podem nos dizer o que um aluno, um cliente ou um suspeito criminal realmente está sentindo ou que tipo de pessoa eles são intrinsecamente está se mostrando atraente para corporações e governos, embora as justificativas científicas para tais alegações sejam altamente questionáveis, e a história de seus objetivos discriminatórios, bem documentada.”

Em um e-mail para o Intercept, Crawford, co-fundadora do AI Now e renomada professora de pesquisa na NYU, juntamente com Meredith Whittaker, co-fundadora do AI Now e cientista pesquisadora da NYU, explicou por que o reconhecimento de emoção é mais preocupante hoje do que nunca, referindo-se a duas empresas que usam aparências para tirar conclusões importantes sobre as pessoas. “Da Faception alegando ser capaz de ‘detectar’ se alguém é terrorista a partir de seu rosto até o HireVue registrando em massa candidatos a empregos para prever se eles serão bons funcionários com base em suas ‘microexpressões faciais’, a capacidade de usar reconhecimento facial e análise maciça de dados para encontrar correlações está levando a algumas alegações muito suspeitas”, disse Crawford.

A Faception tem pretendido determinar a partir da aparência se alguém é “psicologicamente desequilibrado”, ansioso ou carismático, enquanto a HireVue tem classificado candidatos a empregos na mesma base.

Como acontece com qualquer sistema computadorizado de julgamento e tomada de decisões automáticos e invisíveis, o potencial para se ser classificado, sinalizado ou etiquetado erroneamente é imenso com o reconhecimento de emoção, especialmente devido à frágil base científica: “Como uma pessoa descrita por esses sistemas contestaria o resultado?”, acrescentou Crawford. “O que acontece quando contamos com sistemas de inteligência artificial fechados para julgar a ‘vida interior’ ou o valor de seres humanos? Alguns desses produtos citam teorias profundamente controversas que são muito contestadas na literatura psicológica, mas que estão sendo tratadas como fato por startups de IA.”

O que é pior do que a má ciência julgar qualquer um dentro do alcance da câmera é que os algoritmos tomando essas decisões são mantidos em sigilo pelas empresas que os desenvolvem, a salvo de escrutínio rigoroso, por trás de um véu de sigilo comercial. Whittaker, do AI Now, destaca o sigilo corporativo como algo que confunde as práticas já problemáticas de reconhecimento de emoção: “Como a maior parte dessas tecnologias está sendo desenvolvida por empresas privadas, que operam sob as leis de sigilo corporativo, nosso relatório faz uma forte recomendação de proteções para denunciantes éticos dentro dessas empresas”. Tais denúncias continuarão a ser fundamentais, escreveu Whittaker, porque muitas empresas de dados tratam a privacidade e a transparência como um passivo, em vez de uma virtude: “As justificativas variam, mas a maioria [dos desenvolvedores de AI] nega toda a responsabilidade e diz que cabe aos clientes decidir o que fazer com ela”. Pseudociência em parceria com engenharia de computação de última geração com ausência de responsabilização. O que pode dar errado?

Tradução: Cássia Zanon

Sem anúncios. Sem patrões. Com você.

Reportagens como a que você acabou de ler só existem porque temos liberdade para ir até onde a verdade nos levar.

É isso que diferencia o Intercept Brasil de outras redações: aqui, os anúncios não têm vez, não aceitamos dinheiro de políticos nem de empresas privadas, e não restringimos nossas notícias a quem pode pagar.

Acreditamos que o jornalismo de verdade é livre para fiscalizar os poderosos e defender o interesse público. E quem nos dá essa liberdade são pessoas comuns, como você.

Nossos apoiadores contribuem, em média, com R$ 35 por mês, pois sabem que o Intercept revela segredos que a grande mídia prefere ignorar. Essa é a fórmula para um jornalismo que muda leis, reverte decisões judiciais absurdas e impacta o mundo real.

A arma dos poderosos é a mentira. A nossa arma é a investigação.

Podemos contar com o seu apoio para manter de pé o jornalismo em que você acredita?